Dia 1.6B TTS

대화를 위한 초현실적인 AI 음성 모델

Nari Labs에서 개발한 오픈 소스 16억 파라미터 텍스트 음성 변환 모델로, 자연스러운 억양, 리듬, 감정을 담아 사람과 유사한 음성을 생성합니다.

Nari Labs에서 개발한 오픈 소스 16억 파라미터 텍스트 음성 변환 모델로, 자연스러운 억양, 리듬, 감정을 담아 사람과 유사한 음성을 생성합니다.

로딩 중... 3초

Dia 1.6B TTS는 초현실적인 대화 합성을 위해 설계된 최첨단 AI 텍스트 음성 변환 모델입니다. Nari Labs에서 개발하고 Apache 2.0 라이선스로 출시되었으며, 상용 솔루션에 버금가는 자연스럽고 표현력 있는 음성 출력을 제공합니다.

Dia TTS는 사람과 같은 억양, 리듬, 감정을 담아 놀랍도록 자연스러운 음성을 생성합니다. 고급 AI 모델은 실제 사람의 목소리와 거의 구별할 수 없는 음성을 만듭니다.

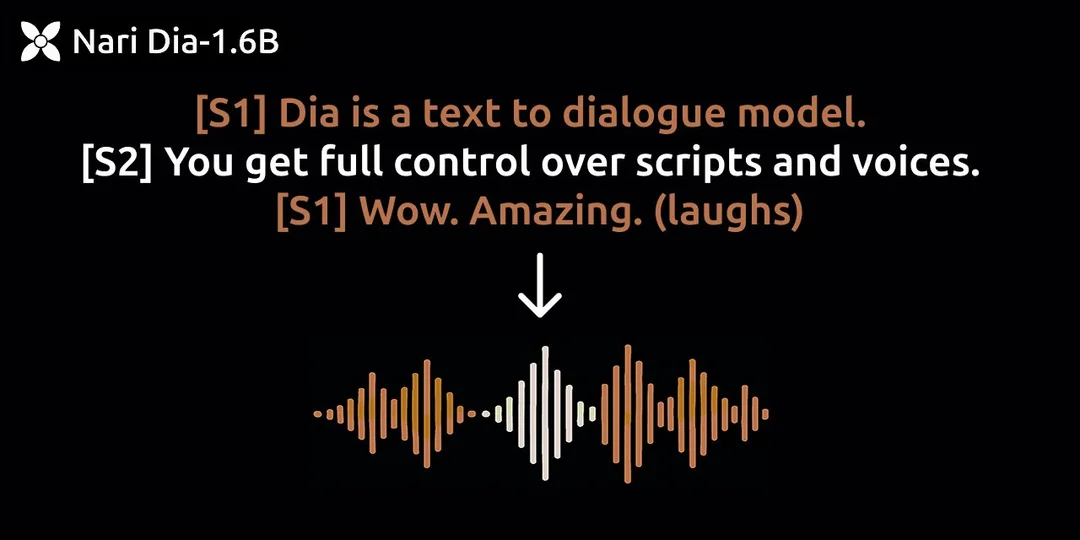

텍스트에 [S1], [S2]와 같은 간단한 태그를 사용하여 여러 화자의 대화를 쉽게 만들고, 일관성 있는 자연스러운 대화를 유지할 수 있습니다.

오디오 프롬프트 기능을 사용하여 특정 음성 특징을 복제하고, 여러 세대에 걸쳐 일관된 음성 정체성을 유지하여 개인화된 음성 출력을 가능하게 합니다.

Apache 2.0 라이선스로 출시되어 개인 및 상업적 목적으로 무료 사용이 가능합니다. 전체 모델 가중치와 코드는 GitHub에서 확인할 수 있습니다.

기본적인 대화 생성 예시.

일상적인 상호작용 시연.

표현력이 풍부하고 감정이 고조된 음성 예시.

기침, 킁킁거림, 웃음소리 포함.

리듬과 플로우 시연.

음성 복제를 위한 오디오 프롬프트 사용 예시.

참고: 오디오 프롬프트로 고품질 출력을 얻으려면 해당 스크립트를 입력 텍스트 앞에 추가하세요. 더 쉬운 사용을 위해 전사를 자동화하는 것을 고려 중입니다.

팟캐스트 생성 가능성 시연.

16억 파라미터 모델 강조.

단일 패스 생성 시연.

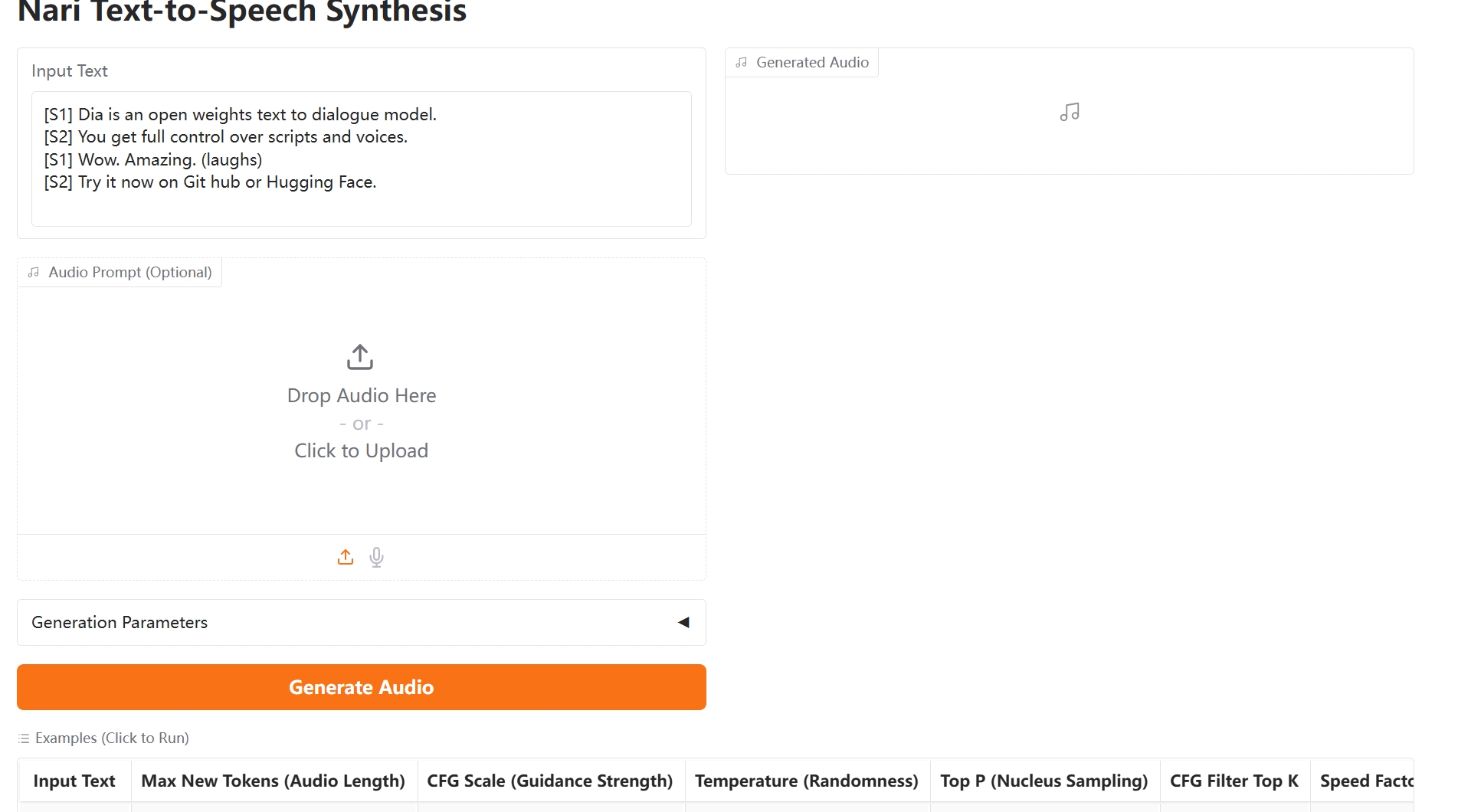

변환하려는 텍스트를 작성하거나 붙여넣으세요. 문장 앞에 [S1], [S2]와 같은 간단한 태그를 사용하여 다른 화자 음성을 할당하세요. (웃음) 또는 (기침)과 같은 비언어적 신호를 포함하여 현실감을 더할 수도 있습니다.

특정 음성을 복제하거나 감정적인 톤을 안내하려면 짧은 오디오 샘플(5-15초)을 업로드하고 해당 샘플의 정확한 전사(화자 태그 포함)를 입력의 기본 스크립트 앞에 추가하세요.

Dia 1.6B TTS 모델을 실행합니다(로컬 앱 또는 온라인 데모 사용). 모델은 전체 스크립트를 한 번에 처리하여 끊김 없는 대화를 생성합니다.

생성된 오디오를 직접 재생합니다. 출력은 자연스러운 억양, 리듬, 비언어적 신호까지 포착하여 초현실적인 청취 경험을 제공합니다. 프로젝트에 사용할 오디오 파일을 다운로드하세요.

### Windows 설치

1. 저장소 복제

git clone https://github.com/nari-labs/dia.git

cd dia

2. 파이썬 가상 환경 생성 (Python 3.10 권장)

python -m venv venv

venv\Scripts\activate.bat

3. 의존성 설치

python -m pip install --upgrade pip

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

pip install -r requirements.txt

4. 모델 가중치 다운로드

# 자동으로 다운로드되거나 Hugging Face에서 수동으로 다운로드할 수 있습니다.

5. 애플리케이션 실행

python app.py### Linux / macOS 설치

# Linux와 macOS의 단계는 일반적으로 동일합니다.

# 전제 조건 확인: Python 3.8+, Git, CUDA 지원 GPU (GPU 사용 시).

# 1. 저장소 복제

git clone https://github.com/nari-labs/dia.git

cd dia

# --- 옵션 A (권장): uv 사용 ---

# uv는 가상 환경과 의존성을 자동으로 처리합니다.

# 아직 설치하지 않았다면 uv 설치: pip install uv

uv run app.py

# --- 옵션 B (수동): venv + pip 사용 ---

# 수동 설정을 선호하는 경우:

# 2. 가상 환경 생성 및 활성화 (Python 3.10 권장)

python -m venv .venv

source .venv/bin/activate

# 3. 의존성 설치

# (가상 환경이 활성화되어 있는지 확인)

# pip 업데이트

python -m pip install --upgrade pip

# CUDA 버전에 맞는 PyTorch 설치 (https://pytorch.org/ 확인)

# CUDA 12.1 예시:

# pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

# CPU 전용 예시 (느릴 수 있음):

# pip install torch torchvision torchaudio

# 기타 요구 사항 설치 (정확한 목록은 pyproject.toml 확인)

pip install -r requirements.txt

# 4. 애플리케이션 실행

# ('dia' 디렉토리에 있고 환경이 활성화되어 있는지 확인)

python app.py

# --- 인터페이스 접속 ---

# 브라우저를 열고 다음 주소로 이동: http://127.0.0.1:7860

# (정확한 URL은 터미널 출력 확인)

### 온라인 데모 사용하기

Hugging Face Spaces에서 Dia TTS를 직접 사용해 볼 수 있습니다:

https://huggingface.co/spaces/nari-labs/Dia-1.6B

1. 페이지 방문

2. 텍스트 입력 (화자 지정을 위해 [S1], [S2] 등 태그 사용)

3. (선택 사항) 오디오 프롬프트 업로드

4. 생성 버튼 클릭

5. 출력 오디오 듣고 다운로드

Dia TTS는 자연스러운 억양, 리듬, 감정을 담아 사람과 유사한 음성을 생성하는 16억 파라미터의 최첨단 텍스트 음성 변환 모델입니다. 엔터프라이즈급 GPU에서는 실시간으로 오디오를 생성할 수 있으며, A4000 GPU는 초당 약 40 토큰을 생성합니다 (86 토큰은 1초 분량의 오디오에 해당).

전체 버전을 실행하려면 약 10GB의 VRAM이 필요합니다. 저사양 하드웨어에서의 접근성을 높이기 위해 양자화된 버전이 향후 업데이트될 예정입니다. (Dia 1.6B TTS)